こんにちは、トロボです。

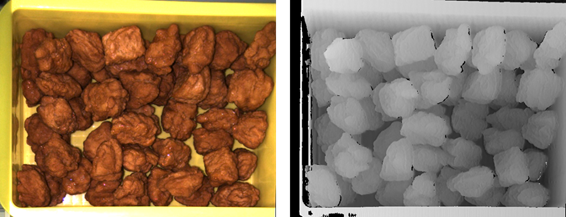

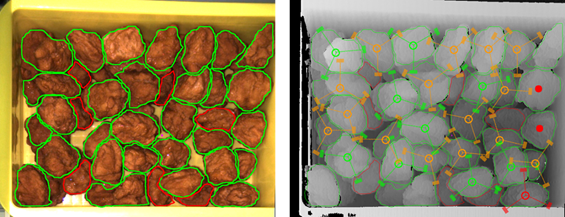

本記事では、バラ積みピッキングにおいてロボットの作業環境、すなわち3次元カメラの視野内のシーンが突然変化しても正確に対象物をピッキングできる認識システムについて紹介します。まずは動画をご覧ください。

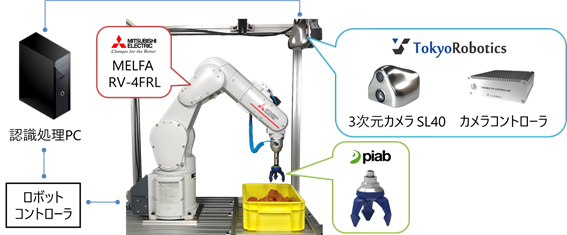

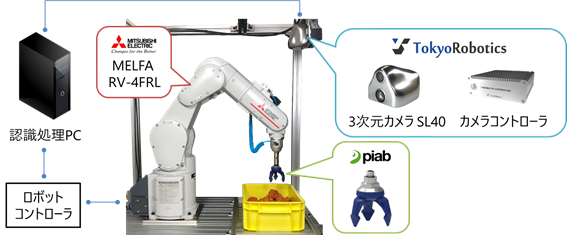

動画で使用しているロボットシステムの構成は、唐揚げピッキングの記事と同様に、下記の図のようになっています。

まず動画の説明をする前に、背景からお話ししたいと思います。ロボットシステムは生産効率を高めるため、なるべく短いタクトタイムで動作することが望まれます。バラ積みピッキングにおけるタクトタイムとは、対象物を計測・認識してロボットが把持を行い、適切な場所に移送する(あるいは組付け等の作業を行う)までの動作を一巡するのに要する時間です。

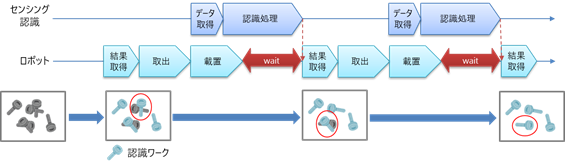

従来では長い処理時間を要していた3次元カメラによる物体認識も、近年では計算機の性能の向上によって短い時間で実行することができるようになってきています。理想的にはロボットが無駄な動作をすることなく高い稼働率でピッキング作業をさせたいところです。しかし対象物や認識処理に用いられるアルゴリズムによっては、性能の良い計算機を用いても処理時間が長くなってしまうケースも少なくありません。そのような場合には、下図のように認識処理の完了待ちのためにロボットは一時停止をせざるを得ません。

このようにロボット動作の合間に待機時間が生じると、タクトタイムが長くなり生産効率が悪くなってしまいます。そこで東ロボで開発している認識エンジンでは、この待ち時間を限りなくゼロにできる独自システムを構築しました(特許出願済み)。

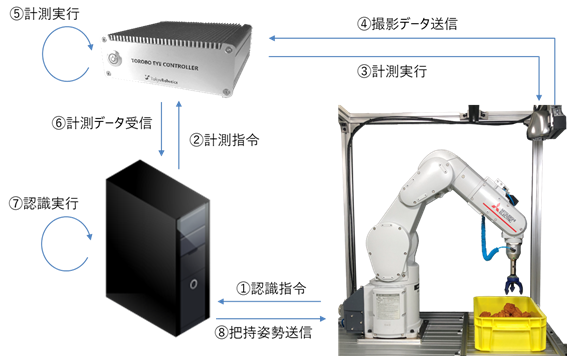

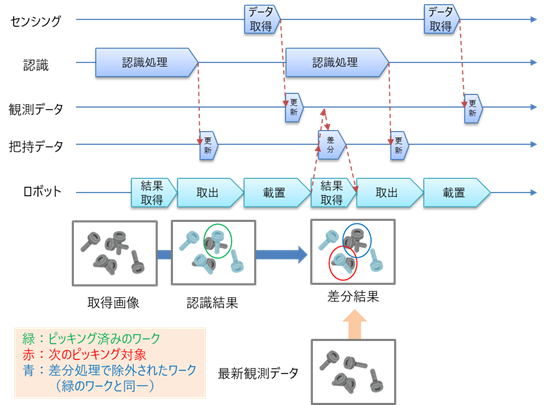

簡潔に説明すれば、認識処理をした結果を直接ロボットに送信するのではなく、観測データや把持の認識結果のデータを別のメモリに保存しておき、認識処理の実行中でも把持データをロボットに送信することができるようにします。これを実現するためのポイントは大まかに2点あります。1つは認識処理と把持データの送信処理はそれぞれ独立して並列処理するようにすること、もう1つは把持データを送信する際に、メモリに記憶された把持データをそのまま送信するのではなく、最新の観測データに基づいて現在使用できない解を除いた(差分した)形で送信することです。この差分処理は、シーンが大きく変化している領域を検出して、その領域に含まれる把持データを削除するだけなので、計算コストが非常に小さく、ロボット動作への影響がほとんどありません。この処理のイメージ図を下図に示します。

このシステムによって、ロボットが認識待ちする無駄な時間をほぼゼロにすることができるうえ、常にシーンの変化をとらえて把持可能な解だけを送信するので、動画のようにドラスティックにシーンが変化しても安定してピッキングを継続することができます。さらに、この一連の処理は認識エンジンの内部で自動的に行われるので、ユーザはまったく意識することなくこのシステムの恩恵を受けることができます。

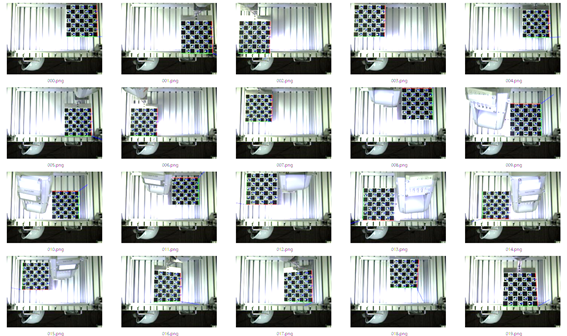

動画をご覧いただくと、認識できていたワークが突然シーンから消えるケースや、逆にワークが出現するケース、ほとんど空だった容器に大量にワークが投入されるケースなど、様々な状況に対してこのシステムが有効に機能することがお分かりいただけると思います。

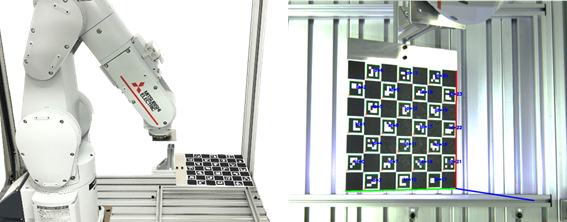

今回は、シーン変化にロバストに対応できる認識システムについてご紹介しました。東ロボの3次元カメラSL40やピッキングロボットについてのお問い合わせは下記アドレスまでどうぞ。

trbe-sales[at]robotics.tokyo

それではまた。