こんにちは、トロボです。

今年も残すところあとわずかとなりましたが、いかがお過ごしでしょうか?

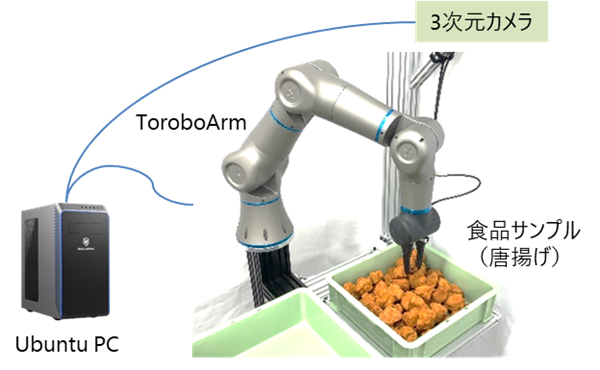

本記事では、前回に引き続きましてTorobo Armによる唐揚げピッキングデモをご紹介します。前回と同じものになりますが、まずは以下の動画をご覧ください。取り出そうとしている唐揚げ(ターゲット)の周辺には複数の唐揚げがランダムに存在していますが、ターゲット以外に触れることなく取り出しができている様子がお分かりいただけると思います。

もしグリッパの爪先と周囲の唐揚げが衝突してしまったら、本物の唐揚げであればつぶれたり衣がはがれてしまったりして売り物にならなくなります。現場で稼働するロボットシステムとしてはスピードを追求しなければなりませんが、それ以前に丁寧にピッキングをすることが前提条件なのです。

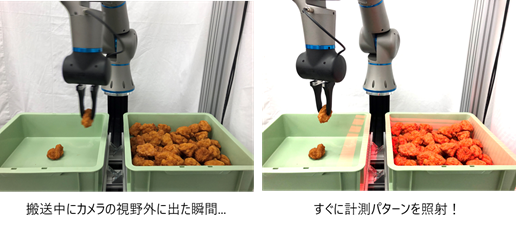

この動画のようにターゲットだけを正確に掴んで取り出すためには、3次元カメラで得られるデータに基づいて、どこにグリッパ爪先を差し込めばよいのか判断する必要があります。そのためにはランダムに積まれた唐揚げの状態を把握する技術が重要になります。そこで第2回となる今回のテーマは、唐揚げの「認識」です。

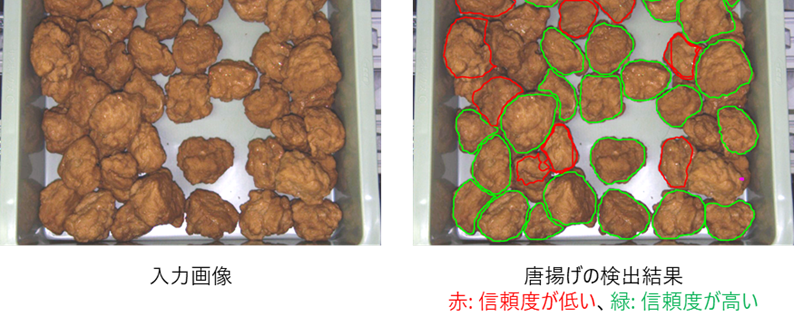

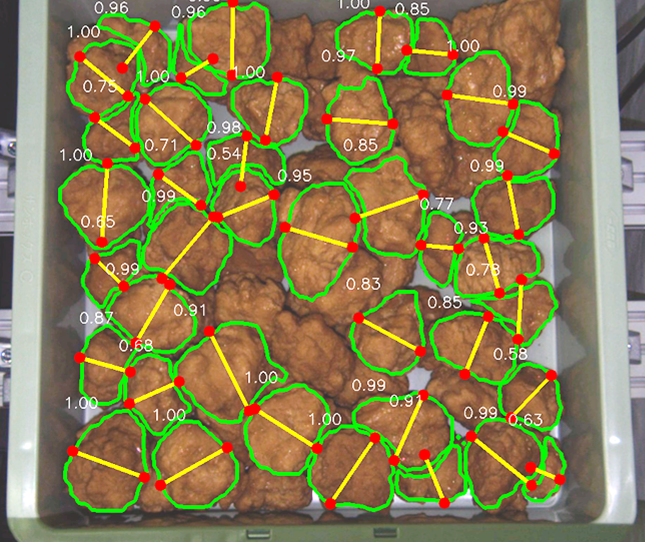

ひとくちに認識と言っても、ピッキングという目的を達成するための手段としては様々なアプローチが考えられますが、今回は唐揚げ一つ一つを切り分けて認識するセグメンテーションという方法を採用しました。実際の検出結果では、唐揚げごとに輪郭情報として取得しています。下図のとおり、唐揚げ一つ一つの形状を捉えられていることが分かります。精度の低い検出結果が含まれることもありますので、検出時に一緒に得られる信頼度の数値によって把持候補にするかどうかを判断しています。

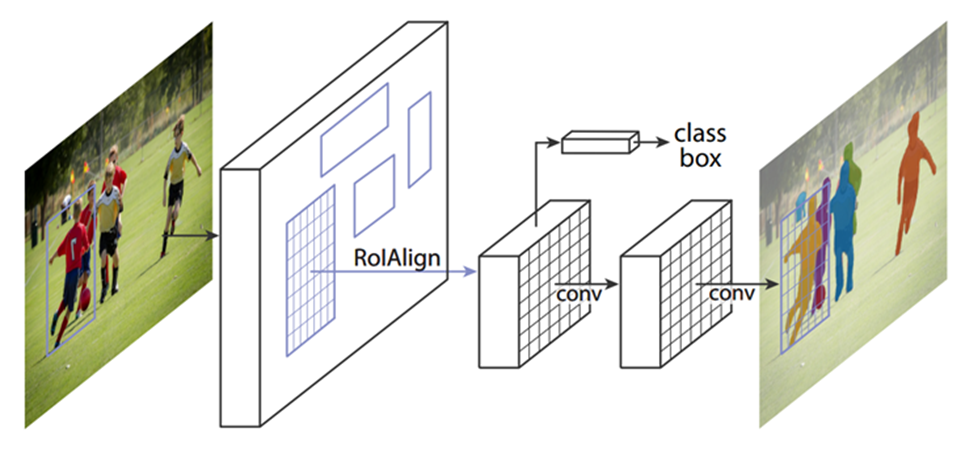

セグメンテーションにはディープラーニングの1種であるMask R-CNN[1]を利用しています。Mask R-CNNは、画像中のどこに、どの物体が存在しているかを画素単位で検出することができる手法です。画素単位で検出結果が得られるので、唐揚げの輪郭を正確に捉えることが可能になります。

Mask R-CNNの概要を大まかに説明すると、認識対象物が存在しうる領域(下図のRoIAlignに該当)を抽出するニューラルネットワークと、抽出した領域ごとにそこに写りこんでいる対象物が何なのか(下図のclassに該当)、どのピクセルが対象物なのか(下図の一番右の画像に該当)を推定するニューラルネットワークから成り立っています。余談ですが、Mask R-CNNは2020年12月26日現在で引用数9390件となっており、世界中に広く認知された手法であると言えます。

さて、唐揚げ一つ一つを切り分けることができましたが、それだけではピッキングすることはできません。唐揚げに対してどの位置・どの向きで把持するべきかを決めなければなりません。今回はシンプルに、唐揚げの重心位置を基準に、唐揚げを楕円形とみなしてその短辺を把持位置とします。下図における2つの赤い点が算出された把持位置を示します。

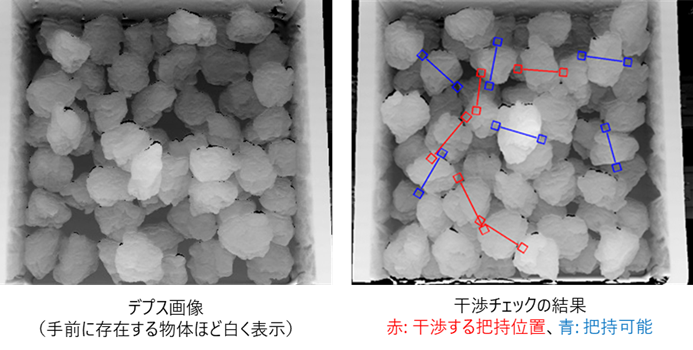

このようにターゲットの形状に基づいて把持位置を決めた場合、その把持位置にグリッパを持っていったときにターゲット以外の物体と衝突しないことが保証されません。そこで把持を実行する前に、衝突するかどうかの事前チェック(干渉チェック)を行います。干渉チェックでは3次元的な判定が必要になりますので、入力データとしてはデプス画像を用います。デプス画像は、その画像に写る物体の奥行きによって色合いを変化させて表現したもので、高さ情報、すなわち3次元の情報を含んでいるので干渉チェックに使うことができます。

把持可能と判定された青色の把持位置を見てみると、そこにはグリッパを差し込む隙間が空いており、干渉すると判定された赤色の把持位置を見てみると、隣接した別の唐揚げがある位置だったりしてぶつかってしまいそうなことが分かります。この青色の把持位置だけをターゲットとすることで、ぶつからずにピッキングができるようになります。なお今回の干渉チェックは独自でS/Wを作成したものですが、従来研究も多数あります。例えば文献[2]などが参考になります。

今回は唐揚げの認識についてご説明しました。第3回は年明け1/15頃にアップ予定です。内容は見てのお楽しみ。。。

今年も大変お世話になりました。

それではみなさま、よいお年をお迎えください。

[1] He, K., Gkioxari, G., Dollár, P., & Girshick, R. (2017). Mask r-cnn. In Proceedings of the IEEE international conference on computer vision (pp. 2961-2969).

[2] Domae, Y., Okuda, H., Taguchi, Y., Sumi, K., & Hirai, T. (2014, May). Fast graspability evaluation on single depth maps for bin picking with general grippers. In 2014 IEEE International Conference on Robotics and Automation (ICRA) (pp. 1997-2004). IEEE.